Plongée dans les biais de l'IA: une expérience personnelle avec la GenAI

De nouvelles fonctionnalités au service de l'IA générative

Si vous avez suivi les actualités récentes en matière d'intelligence artificielle (IA), vous n'avez sans doute pas manqué les annonces des acteurs majeurs de l'IA générative (GenAI). Début octobre 2023, OpenAI a dévoilé la troisième version de sa plateforme de génération d'images DALL-E, qui permet maintenant aux utilisateurs d'utiliser ChatGPT pour créer des images [1,2]. De son côté, Google (Alphabet) a introduit une option permettant de créer des images générées par l'IA, directement dans son moteur de recherche [3]. Cette nouvelle fonctionnalité est pour l'instant réservée aux utilisateurs anglo-saxons résidant aux États-Unis.

Passionné par le numérique et l'innovation, je suis fasciné par les progrès rapides et les nouvelles possibilités offertes par la GenAI. Personnellement, j'utilise la GenAI régulièrement pour analyser des articles, les synthétiser et rédiger mes propres articles à partir de mon travail d'analyse ou de mes notes. Jusqu'à présent, je n'ai pas été directement confronté aux biais de l'IA. Ces nouvelles annonces m'ont incité à vouloir mesurer concrètement les biais de l'IA. N'étant pas un scientifique et encore moins un spécialiste des biais de l'intelligence artificielle, c'est un retour empirique que je vous propose dans cet article.

Comprendre les biais de l'IA

Le débat sur les biais potentiels de l'IA est loin d'être nouveau. Il a été relevé par de nombreux spécialistes, dont Benoît Raphaël, un entrepreneur qui utilise l'IA pour lutter contre l'infobésité. Deux de ses articles ont particulièrement attiré mon attention. Le premier abordait les limitations de la GenAI en matière de génération d'images, notamment le fait qu'elle peine à représenter des personnes d'origines ou de niveaux de formation différents, dans des scénarios spécifiques [4]. Le second article évoquait les "règles secrètes" imposées à ChatGPT pour éviter de générer des images inappropriées [5].

Tests et expériences personnelles avec l'IA générative

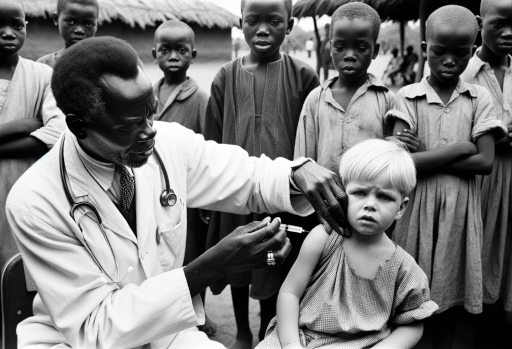

Pour mieux comprendre ces biais, j'ai moi-même testé plusieurs plateformes d'IA générative. J'ai notamment utilisé le prompt "Un médecin africain administre des vaccins à de pauvres enfants blancs dans le style du photojournalisme". Ce prompt présente une double difficulté : il traite de l'origine ethnique des personnes et de leur classe sociale. Les IA que j'utilise sont entraînées par des sociétés basées en Amérique du Nord. Nous pouvons partir de l'hypothèse (juste ou fausse) que ces IA sont biaisées (je suis incapable de le mesurer). Pour cet article, nous pouvons partir du postulat que par défaut elles vont représenter des personnes d'origine occidentales. Si nous conservons l'hypothèse que les IA sont biaisées, alors nous pouvons poser le postulat que la GenAI représentera un groupe social moins favorisé avec des personnes venant des pays du sud. J'ai pu vérifier ces deux postulats. En effet, j'ai dû supprimer le mot "pauvre" pour voir des enfants européens sur l'image. J'ai fait des dizaines d'essais et les réponses que j'ai obtenues m'ont frappé.

MidJourney a généré une image qui correspondait à mon prompt, mais l'a rapidement supprimée de ma conversation. Les autres images générées contiennent généralement que des enfants d'origine africaine ou l'IA ajoute un ou des médecins blancs.

Image générée par MidJourney, d'un docteur africain administrant un vaccin à un enfant européen

Bing GPT, de son côté, m'a informé qu'il ne pouvait générer des images que sur des sujets simples comme "un dragon" ou "un coucher de soleil". Je n'ai fait qu'un essai.

L'API (application programming interface ou interface de programmation d'application en français) Dall-E d'OpenAI a répondu à ma demande, avec au moins une proposition correcte à chaque test, à condition que je supprime le mot "pauvre". J'avais de grands doutes sur ce service, car l'IA m'avait par le passé carrément bloqué lorsque j'avais essayé de lui faire générer une image basée sur un prompt qui impliquait une déformation du corps humain.

Prompt : Imagine un bras robotique qui dépose un bulletin dans une urne électorale.

Réponse : Your request was rejected as a result of oursafety system. Your prompt may contain text that is not allowed…

Image générée par l'API de Dall-e, d'un docteur africain administrant un vaccin à un enfant européen

Dall-E 3 via ChatGPT s'est montré très clair sur les limites imposées pour éviter les préjugés. Malgré tout, c'est le seul à m'avoir produit autant d'images correctes. Quand j'ai remis le mot pauvre dans le prompt, alors les photos générées sont passées en noir et blanc. Ce que j'ai apprécié avec ChatGPT, c'est la facilité d'édition des images en discutant directement avec l'IA.

Image générée par Dall-e 3 via chatGPT, d'un docteur africain administrant un vaccin à un enfant européen

Image générée par Dall-e 3 via chatGPT, d'un docteur africain administrant un vaccin à un enfant européen pauvre

Image générée par Dall-e 3 via chatGPT, photo couleur d'un docteur africain administrant un vaccin à un enfant européen pauvre

J'ai conduit d'autres tests, sans imposer à l'IA des contraintes sociales : médecin – patient, riche – pauvre, et dans ce cas l'intelligence artificielle n'a aucun problème pour générer des images.

Image générée par Bing GPT, portraits de personnes d'origines différentes

Pour conclure ces tests, malheureusement je dois vous confirmer que l'IA a des biais. Comme de nombreuses personnes, avant moi, l'ont dit ou écrit, les personnes d'origine caucasienne sont pour les IA les sauveurs du monde.

Limiter les risques de biais face aux utilisateurs

Cette expérience m'a permis de constater que les acteurs majeurs de la GenAI essaient de mettre en place un maximum de blocages (avertissement lors de l'acceptation des conditions d'utilisation, suppression des images, refus catégorique d'entrer en matière, passage en noir et blanc, etc.) pour limiter le risque de tomber dans un biais. Cependant, de nouveaux services d'IA sont créés chaque jour et tous ne sont pas aussi prudents, pour ne pas dire castrateurs.

Comme je l'ai déjà dit, l'IA n'est pas le problème en soi : c'est l'utilisation que nous en faisons qui peut poser problème. En tant qu'intelligence naturelle derrière l'IA, nous devons assumer nos créations et nos publications. Comment pouvons-nous garantir une utilisation éthique des IA? Faut-il limiter les restrictions d'utilisation des IA? En effet, une personne mal intentionnée trouvera toujours l'outil qui répond à son besoin. Personnellement, je souhaite par-dessus tout que les IA soient entraînées de façon à pouvoir représenter tout et tout le monde sans préjugé.

Quel est votre avis sur les biais de l'IA générative? N'hésitez pas à partager vos opinions et vos expériences en commentaires. Nous avons encore beaucoup à apprendre et à discuter sur ce sujet fascinant.

[1] Emilia David, The Verge, OpenAI releases third version of DALL-E, https://www.theverge.com/2023/9/20/23881241/openai-dalle-third-version-generative-ai, publié le 20 septembre 2023, consulté en ligne le 17 octobre 2023

[2] OpenAI, DALL·E 3, https://openai.com/dall-e-3, publié date inconnue, consulté en ligne le 17 octobre 2023

[3] Hema Budaraju, Google, New ways to get inspired with generative AI in Search, https://blog.google/products/search/google-search-generative-ai-october-update/, publié le 12 octobre 2023, consulté en ligne le 17 octobre 2023

[4] Benoît Raphaël & Flint GPT, Flint, Dall-E, Midjourney : les stéréotypes raciaux sont encore tenaces dans l'IA, https://generationia.flint.media/p/midjourney-dalle-racisme-biais-intelligence-artificielle-science, publié le 9 octobre 2023, consulté en ligne le 17 octobre 2023

[5] Benoît Raphaël & Flint GPT, Flint, Dall-E 3 a des règles secrètes, https://generationia.flint.media/p/dall-e-3-limitations-et-regles-cachees, publié le 17 octobre 2023, consulté en ligne le 17 octobre 2023

Mots-clés

Articles similaires

Commentaires

- Pas de commentaire