IA et sécurité des données: naviguer entre innovation et prudence

Laissez-moi vous embarquer dans une réflexion autour de l'Intelligence Artificielle générative (GenAI), cette technologie que j'utilise au quotidien pour insuffler de la créativité dans mon travail. Dans un précédent article, je vous ai présenté un exemple de son utilisation avec la tradition bulgare des kasmeti. La GenAI est, pour moi, une source d'inspiration inépuisable, que ce soit pour synthétiser des documents, rédiger des articles pour ce blog ou encore pour le blog "les brèves d'Olivier". Je la vois comme une forme d'intelligence collective qui stimule ma créativité. Elle excelle aussi dans la création d'images, la traduction de textes et la transformation de données ouvertes en articles captivants, comme avec les données issues d'une votation ou d'une élection.

Cependant, je reste vigilant et je ne l'emploie pas en tant que simple moteur de recherche pour des questions pointues, en raison de sa tendance aux "hallucinations". Pour ces cas spécifiques, je préfère des outils plus fiables, comme Microsoft Copilot (anciennement Bing GPT), qui cite ses sources et offre une information plus transparente.

La sécurité des données

Des chercheurs de l'Université de l'Indiana ont récemment percé les défenses de ChatGPT [1], révélant des données sensibles, comme des adresses e-mail personnelles, issues du corpus d'entraînementd'OpenAI. Cet incident soulève des questions pressantes sur la confidentialité et la gestion des informations par les fournisseurs de services d'IA, comme OpenAI.

La protection de nos données personnelles est essentielle lorsque nous utilisons des services d'IA en ligne, tels que ChatGPT, les services de traduction basé sur l'IA comme DeepL, ou des applications cloud. Lors d'un "lunch seminar" organisé par Pulse à la HES-SO de Genève en décembre 2023 [2], un participant a interrogé la salle sur les risques liés à l'utilisation de services de traduction en ligne basés sur l'IA, en termes de protection des données. Cette interrogation m'a rappelé les débuts du cloud computing et les préoccupations liées au Patriot Act américain.

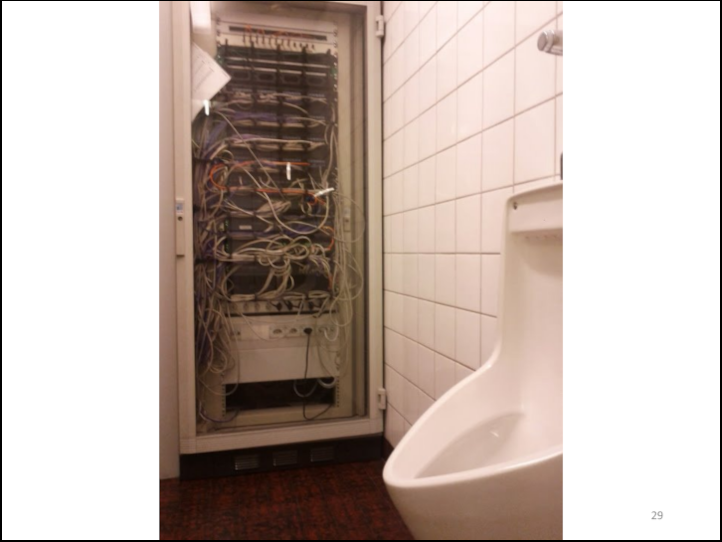

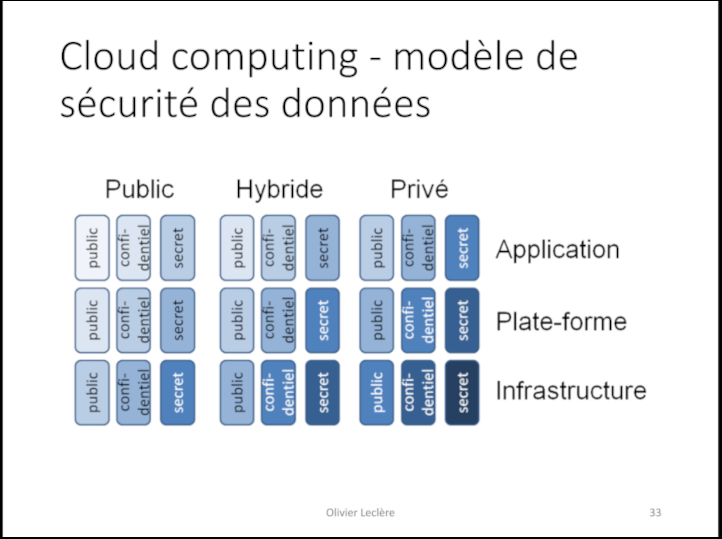

Pour illustrer l'enjeu de la confidentialité et du contrôle des données, lors de cours que j'ai donné, j'utilisais volontiers des diapositives explicatives.

Qui peut accéder à vos données? Tous ceux qui ont accès aux toilettes.

Plus la couleur est foncée, plus vous avez la maitrise des données. Sur une "infrastructure" "privée" vous avez le contrôle de la machine et des données. Dans une "application" "publique", tout comme dans les toilettes ci-avant, vous ne savez pas qui verra vos données.

Elles (les images des slides ci-avant) montrent que la maîtrise de l'infrastructure est directement corrélée à la sécurité des données. Opter pour une gestion "on premise" et contrôler les données d'entraînement sont des stratégies de prudence pour minimiser les risques. Sans contrôle physique sur les solutions d'IA, il convient de se limiter au transfet vers ces systèmes de données publiques. Ignorer cette règle peut avoir des conséquences graves, telles que la divulgation de vos informations à des tiers ou l'influence par vos propres réflexions sur les réponses que donnera l'IA aux autres utilisateurs.

Ce principe de prudence ne se limite pas à l'IA ou au cloud, mais s'applique à tout transfert de données hors de l'infrastructure informatique de votre organisation. Dans un environnement concurrentiel, protéger votre savoir-faire est vital.

Dans cette dynamique où sécurité et confidentialité sont prioritaires, une alternative séduisante émerge: l'utilisation de modèles d'IA open source préentraînés. Ces modèles, comme LLaMA 2 de Meta ou Mistral AI, peuvent être hébergés sur des serveurs privés, offrant souveraineté et personnalisation sans dépendre de prestataires externes.

Comment protégez-vous vos données dans ce monde numérique en constante évolution? Je vous invite à partager vos pensées et à rejoindre la discussion en commentant ci-dessous. Votre avis compte, échangeons pour avancer ensemble dans la compréhension de ces technologies qui façonnent notre avenir.

[1] Florian Bayard, 01net, ChatGPT : une faille de sécurité menace la vie privée sur Internet, https://www.01net.com/actualites/chatgpt-faille-securite-menace-vie-privee-ligne.html, publié le 26 décembre 2023, consulté le 4 janvier 2024 en ligne

[2] Pulse, Lunch seminar : Prompt Futur, https://www.hesge.ch/heg/actualites/2023/lunch-seminar, événement en présentiel 15 décembre 2023

Illustration générée par Dall-e

Mots-clés

Articles similaires

Commentaires

- Pas de commentaire